Von RAFAŁ WAŚKO (Predictive Solutions)

Der Grundgedanke der Regression besteht darin, den Wert einer abhängigen Variablen (auch Prädiktor, erklärte Variable genannt) auf der Grundlage einer oder mehrerer unabhängiger Variablen (Prädiktoren, erklärende Variablen genannt) vorherzusagen.

Die einfachste Form der Regression ist die einfache lineare Regression, die davon ausgeht, dass nur ein Prädiktor zur Erklärung der abhängigen Variable verwendet wird. Es sei jedoch darauf hingewiesen, dass es viele weitere Regressionstechniken gibt, die die Erstellung sehr komplexer Modelle ermöglichen, die in der Wirtschaft, aber auch in anderen Bereichen wie der Fertigung, der Wettervorhersage, dem Handel, dem Gesundheitswesen oder der Landwirtschaft eingesetzt werden können. Als Beispiel können wir die Vorhersage des Autowertes auf der Grundlage des Hubraums, der Kilometerleistung und der Anzahl der Jahre der Nutzung anführen. Ein anderes Beispiel wäre ein lineares Regressionsmodell, in dem wir die Höhe des Einkommens auf der Grundlage von Prädiktoren wie der Anzahl der Schuljahre, dem Intelligenzniveau, dem Sozialkapital oder der elterlichen Bildung vorhersagen wollen. Natürlich ist die Zahl der praktischen Anwendungen noch viel, viel größer. Begrenzt werden wir nur durch unsere Vorstellungskraft und durch die Notwendigkeit, einige Annahmen einzuhalten (ich werde sie weiter unten erläutern).

WAS IST REGRESSIONSANALYSE?

Der Analytiker erstellt ein so genanntes Regressionsmodell, um die Frage zu beantworten, welchen Wert eine Variable annimmt, wenn er den Wert einer anderen Variablen kennt. Nach einer wissenschaftlicheren Definition ist die Regression eine statistische Technik, die es ermöglicht, die Kovarianz mehrerer Variablen durch die Anpassung von Funktionen zu beschreiben. Bei der Regressionsanalyse können zwei Hauptziele unterschieden werden: Untersuchung des Umfangs und der Struktur der Beziehung zwischen den Variablen (1) und Vorhersage des Wertes einer Variablen auf der Grundlage der Beziehung zu einer anderen Variablen oder einer Gruppe von Variablen (2).

GLEICHUNG DER EINFACHEN LINEAREN REGRESSION

Die Gleichung für eine einfache lineare Regression ist ähnlich wie die Gleichung einer linearen Funktion. Wir können die Formel für die lineare Regression schreiben:

Wobei:

y – abhängige Variable (erklärte Variable, Prädiktor),

x – unabhängige Variable (Prädiktor),

a – freier Ausdruck, der auch als Konstante bezeichnet wird,

x – Regressionskoeffizient, der auch als Richtungskoeffizient bezeichnet wird.

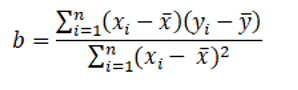

Zur Berechnung des Regressionskoeffizienten wird die folgende Formel verwendet:

Wobei:

b – Regressionskoeffizient,

xi – Ergebnisse für die unabhängige Variable, aufeinanderfolgende Beobachtungen der erklärenden Variable,

yi – Ergebnisse für die abhängige Variable, konsekutive Beobachtungen der erklärenden Variable,

x – Mittelwert der unabhängigen Variablen,

y – Mittelwert der abhängigen Variablen.

Die Berechnung des freien Ausdrucks ist bereits einfach. Dazu verwenden wir den zuvor berechneten Regressionskoeffizienten und den Mittelwert für die unabhängige Variable und die abhängige Variable.

INTERPRETATION DES REGRESSIONSKOEFFIZIENTEN UND DES FREIEN AUSDRUCKS

Bei der einfachen linearen Regression werden zwei Hauptkoeffizienten bestimmt. Der erste ist der Koeffizient b bzw. der unstandardisierte Regressionskoeffizient. Bezogen auf die Regressionsgerade bestimmt dieses Maß den Neigungswinkel der Geraden in Bezug auf die X-Achse. Er wird auch als Richtungskoeffizient bezeichnet. Durch Einsetzen der Werte in die lineare Regressionsformel bestimmt der Regressionskoeffizient, um wie viel sich der Wert der abhängigen Variablen erhöht oder verringert, wenn sich der Prädiktorwert um eine Einheit ändert. Der Koeffizient b in einem linearen Regressionsmodell ist notwendig, um den Wert der abhängigen Variable vorherzusagen. Um lineare Regressionskoeffizienten zu erhalten, können wir die Methode der kleinsten Quadrate (MNK) anwenden. Bei dieser Methode wird die Summe der Quadrate der Abstände aller Punkte von der gewünschten Geraden minimiert.

Im Falle des freien Ausdrucks gibt dieses Maß Aufschluss darüber, welchen Wert die abhängige Variable annehmen kann, wenn der Prädiktor Null ist. Es ist jedoch zu beachten, dass die Ergebnisse in diesem Fall mit Vorsicht zu interpretieren sind. Der Wert der freien Ausprägung kann negativ sein, bedeutet aber nicht, dass die unabhängige Variable auch negative Werte annehmen kann, z. B. in dem Modell, in dem wir die Anzahl der Kalorien in Bier (abhängige Variable) auf der Grundlage des Alkoholgehalts (unabhängige Variable) vorhersagen, kann der Wert der freien Ausprägung negativ sein, was nicht bedeutet, dass alkoholfreies Bier negative Kalorien hat.

ANNAHMEN ZUR LINEAREN REGRESSION

Die lineare Regression ermöglicht die Verwendung von quantitativen Variablen mit Normalverteilung. Bevor jedoch eine Regressionsanalyse durchgeführt wird, sollte sich der Analyst vergewissern, dass die Annahmen für diese statistische Technik erfüllt sind.

Es lassen sich vier Hauptannahmen im Zusammenhang mit dem linearen Regressionsmodell identifizieren:

– Linearität – es besteht eine lineare Beziehung zwischen der unabhängigen Variable und der abhängigen Variable.

– Homoskedastizität – die Varianz der Residuen ist für alle Beobachtungen gleich.

– Die Zufallskomponente (Residuen) sind unkorreliert und weisen eine Normalverteilung auf.

– Unabhängigkeit der Variablen – keine der unabhängigen Variablen kann mit einer anderen unabhängigen Variablen korreliert sein (gilt für die multivariate Regression).

BEISPIEL FÜR EINE EINFACHE LINEARE REGRESSION

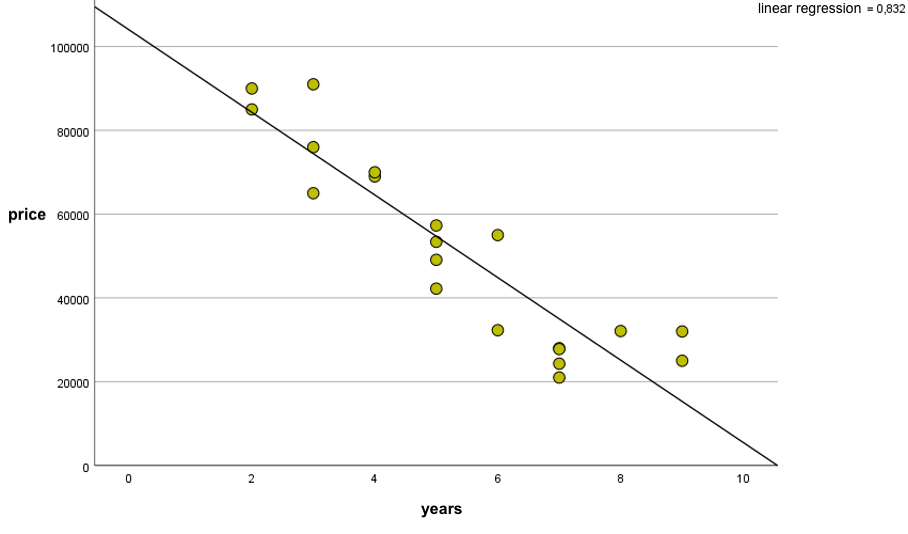

Betrachten wir ein einfaches Beispiel, bei dem wir den Preis eines Autos (die abhängige Variable) auf der Grundlage der Anzahl der Jahre, die ein Auto existiert (die unabhängige Variable, der Prädiktor), vorhersagen wollen. Natürlich kann der Preis eines Autos auch von anderen Variablen beeinflusst werden, aber um den Leser in die lineare Regression einzuführen, werde ich nur einen Prädiktor verwenden. Bei der linearen Regressionsanalyse wird, wie der Name schon sagt, davon ausgegangen, dass die Beziehung zwischen zwei Variablen eine lineare Beziehung ist. Wenn wir die Daten in einem Streudiagramm darstellen, sehen wir, dass die Variablen negativ korreliert sind, d. h. mit zunehmendem Alter eines Autos sinkt sein Preis[1].

Abbildung 1. Beziehung zwischen Gebrauchtwagenpreis und Anzahl der Jahre mit der Regressionslinie

Bei der linearen Regressionsanalyse wollen wir eine Linie zeichnen, die am besten zu den Punkten im Streudiagramm passt. Wir können die Methode der kleinsten Quadrate verwenden, mit der wir eine Regressionslinie zeichnen können, die am besten zu den gesammelten Daten passt. Zu diesem Zweck berechnen wir den Koeffizienten b (Regressionskoeffizient) und den Wert des freien Ausdrucks a.

Nachdem wir diese Werte berechnet haben, können wir sie in die Formel für die einfache lineare Regression einsetzen. Für unsere Daten lauten die Parameter:

• Regressionskoeffizient(b) = -9860,

• Konstante /free expression (a) = 104 029.

Wir können daher die lineare Regressionsgleichung wie folgt formulieren:

Preis (price) = 104029 – 9860 * Jahre (years)

Aus der Interpretation des Regressionskoeffizienten ergibt sich, dass das Auto mit jedem Jahr 9860 PLN an Wert verliert. Im Falle eines freien Ausdrucks stellt der Wert von 104.029 PLN den Betrag dar, der für ein neues Auto gezahlt werden müsste.

Wenn der Analyst den Preis des nächsten Autos vorhersagen möchte, genügt es, die Anzahl der Jahre des Autos, für das wir eine Vorhersage treffen wollen, in die Formel einzutragen. Für ein Auto, das 6 Jahre alt ist, würde das Ergebnis beispielsweise 44.869 PLN betragen.